潞晨尤洋:视频生成的GPT-4时刻,3年后可以见证 | MEET 2025

发布日期:2025-02-02 15:35 点击次数:136

剪辑部 发自 凹非寺

量子位 | 公众号 QbitAI

奥特曼说,Sora代表了视频生成大模子的GPT-1时刻。

从开年到当今,国表里、初创独角兽到互联网大厂,齐纷纷插足视频生成领域,带来一个个簇新模子的同期,视频、影视行业也随之发生剧变。

不可否定,当下的视频生成模子还遭遇诸多问题,比如对空间、对物理规则的结伙,咱们齐期待着视频生成的GPT-3.5/4时刻到来。

在国内,有这么一家从加快测验启航的初创公司,正在为此死力。

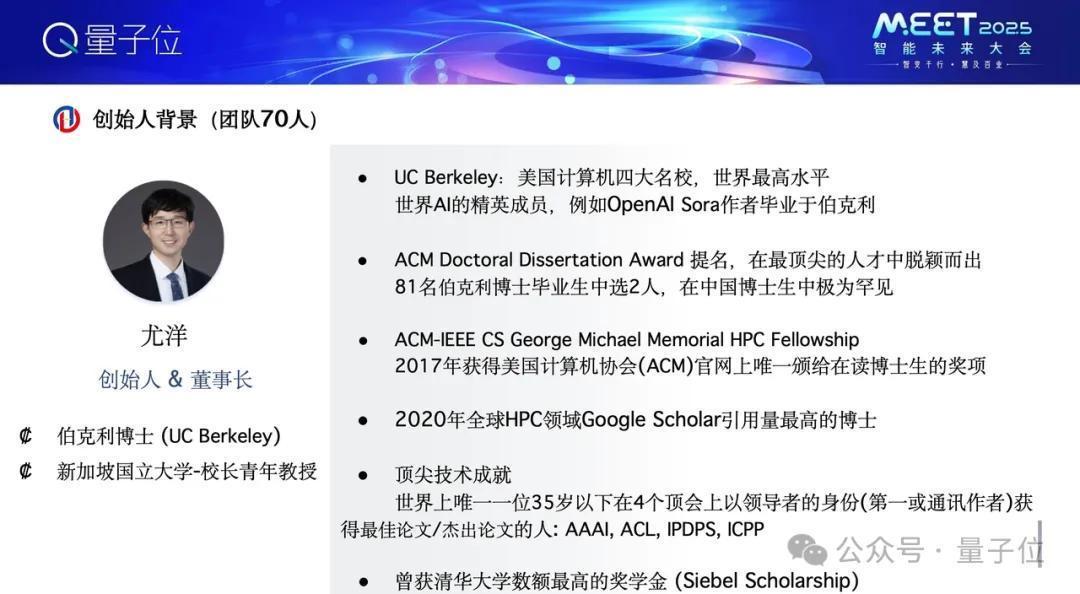

它等于潞晨科技,首创东谈主尤洋博士毕业于UC伯克利,后赴新加坡国立大学担任校长后生解释。

本年潞晨科技在加快研究领域以外,配置视频生成模子VideoOcean,为行业带来更具性价比的采取。

在MEET 2025现场,尤洋博士也向咱们共享这一年关于视频生成领域的结伙与默契。

MEET 2025智能昔时大会是由量子位主持的行业峰会,20余位产业代表与会谋划。线下参会不雅众1000+,线上直播不雅众320万+,取得了主流媒体的豪迈温煦与报谈。

中枢不雅点梳理视频生成模子应该已毕细致化文本适度、猖狂机位/猖狂角度、变装一致性、作风定制化3年后大致就能迎来视频生成的GPT-3.5/GPT-4时刻视频生成大模子的一个径直专揽价值等于冲破现实的扬弃,极大缩短实在场景复现难度。(为更好呈现尤洋的不雅点,量子位在不更动承诺的基础上作念了如下梳理)

3年后或是视频大模子的GPT-3.5时刻今天相配鼎沸来到量子位大会,相配鼎沸和人人疏导,今天讲一下咱们在视频大模子领域作念的一些责任。

最初是我和我的创业公司潞晨科技的先容。我从UC伯克利毕业到新加坡国立大学任教,很运气创办了潞晨科技。

咱们之前是作念算力优化的。2018年谷歌打造了寰球上第一个千卡集群TPU Pod,其时寰球上最大的模子也曾BERT。咱们匡助谷歌,将(其时)寰球上最大模子的测验时辰从3天压缩到76分钟。

也很运气,前年华为盘古大模子的一个责任亦然咱们沿途来作念的,并取得了ACL最好论文。咱们的工夫匡助华为盘古大模子在测验中更高效。微软、英伟达等公司团队也使用了咱们的工夫作念一些散播式测验,咱们但愿让大模子测验更快、资本更低。

步入今天的话题,来要点先容一下视频生成大模子。

咱们打造了一个产物叫Video Ocean,当今正处在测试阶段。先来先容一下产物,背面再研讨我认为视频大模子将会如何发展。

最初,我认为视频大模子第一个辛苦的方面是,它应该能够已毕细致化的文本适度。

其实咱们今天齐在用AI去生成大模子了,咱们笃定但愿它能够精确反应出念念要的东西。但很缺憾,比如当今用文生图APP去生成图顷刻,也曾会发现许多图片本质无法作念到精确适度,是以我认为这方面还有很大的发展空间。

在Video Ocean模子测验经由中,咱们作念了一些初步探索。一个相比好的例子,咱们能够精确地提供一些描画,戴着墨镜,长的胡茬的欧洲男东谈主。可想而知这个视频内部确乎是咱们念念要的阿谁嗅觉,蓝天、海岸、沙滩、背光、单手捏相机、玄色T恤,也有对着镜头言语。

我认为AI视频大模子昔时3年可能最辛苦的也曾已毕视频大模子的Scaling Law。

这个经由不需要相配炫酷的产物材干,最辛苦的是把它的模子与现实寰球的畅达材干作念到极致。我认为最终形态等于东谈主们说一段话、给一段描画,它能精确地把描画以视频的样子展示出来。

是以我认为昔时3年,AI视频大模子就像山姆·奥特曼说的那样,今天是Video的GPT-1时刻,可能3年后到视频大模子的GPT-3.5、GPT-4时刻。

这里展示一下Video Ocean的Demo,目下咱们作念到了这么的水平。

潞晨科技

,赞687

第二点是昔时视频大模子若何能够已毕猖狂机位、猖狂角度。

当今拍电影、拍记录片可以拿入辖下手机、录像机禁止地晃,念念如何晃就如何晃,这么是对镜头有实在适度的。昔时AI视频大模子,最初应该作念到这少许,通常的描画,换一下角度、换一个镜头,它的形象是不应该更动的,它等于通常一个物体。

更进一步讲,昔时AI视频大模子还能颠覆许多行业。比如当今看足球、看篮球赛,咱们看到的镜头是现场编导给咱们看的镜头。他给咱们看前景、近景。

昔时能不成依靠AI视频大模子,东谈主来适度镜头,决定念念要看哪,终点于在表现场里可以瞬息迁徙,迁徙到老师席、临了一瞥、第一瞥。猖狂机位、猖狂角度的适度。我认为昔时AI视频大模子在这方面也长短常环节的,天然天然Video Ocean当今作念了一些尝试,初步恶果也曾可以的。

我认为第三点辛苦的是变装一致性。

因为作念出AI视频大模子,最终笃定是需要产生营收、已毕变现的。谁会自得为这个付费,比如告白责任室、告白商、电商博主、影视行业。要是深切这些行业的话,一个环节点是变装一致性。

比如一个产物的告白,笃定重新到尾这个视频中的衣着、鞋、车,样貌不成有太大变化,物体变装保捏一致性。

拍一部电影,从滥觞到完毕,主演的样貌、环节副角的样貌笃定也不成变化,在这方面Video Ocean也作念一些很好的探索。

再一个是作风的定制化。咱们知谈当今演员东谈主工资本长短常贵的,谈具资本也很高。

昔时3年之内,要是AI视频大模子普遍发展,我嗅觉会有一种需求,比如一个导演可以让一个演员在拍浮池里拍一段戏,然后拿到素材通过AI将它转成泰坦尼克场景下的拍浮,转成阿凡达场景下的拍浮,这种材干反而是AI最擅长的。赋予电影感、艺术感的画面。

总之大模子一个径直的专揽价值等于冲破现实的扬弃,能够极大缩短实在场景复现的难度。

可能之前人人听过一个段子,好莱坞导演念念制造一个爆炸镜头,他算了一下预算,第一种决策是盖一个城堡把它炸掉,第二个决策是用研究机模拟这个画面。资本算下来之后,发现这两种决策的资本齐很高,其时用研究机模拟的资本更高,当今AI等于要大幅缩短大模子关于生成电影的资本。

要是这少许已毕后,咱们可以不受面孔、天气等外部身分的扬弃,并减少对实在演员的依赖。这倒不是抢演员的饭碗,因为一些环节镜头长短常危急的,比如演员跳飞机、跳楼,演员去转圜行将引爆的炸弹之类,这种镜头昔时只需要演员的身份和肖像权,AI可以把这么的镜头作念好,是以对电影行业能够极大作念到降本增效。

正如昆仑万维方汉老师刚才说的,诚然咱们的研究资源有限,然而咱们发现通过更好的算法优化确乎能够训出更好的恶果,比如Meta使用6000多个GPU测验30B的模子,最近咱们会在一个月内发一个10B版的模子,咱们仅用了256卡。

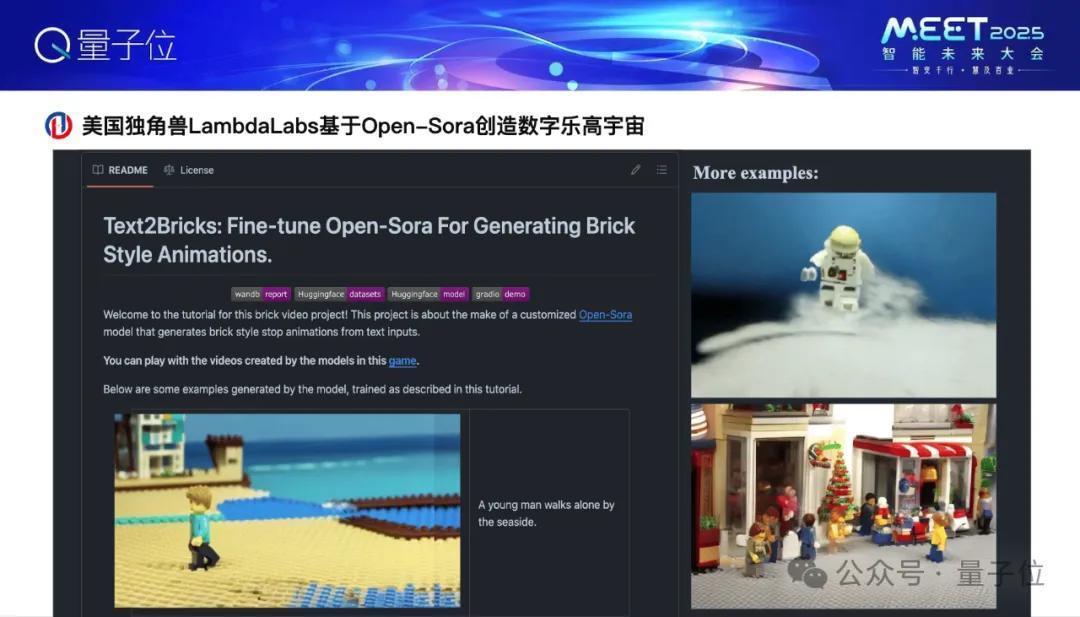

Video Ocean前身是咱们团队先打造了一个Open-Sora的开源产物,这个开源产物是扫数免费的,在Github上,恶果相配可以,比如好意思国独角兽Lambda labs作念了一个火爆的专揽数字乐高,其实这个数字乐高档于基于Open-Sora作念的。

本年事首Sora出来之后,各式短视频巨头齐对视频大模子这一块相比怜爱,比如中国的快手、抖音,好意思国等于Instagram、TikTok、SnapChat,这可以看到SnapChat的视频模子也在早些时候发布了,叫Snap Video,这是它的官方论文,他们就援用了咱们测验视频大模子的工夫,是以说这些工夫也匡助一些巨头实在把视频大模子训得更快,精度更高,智能进度更高。

谢谢人人!

点击https://video.luchentech.com可体验Video Ocean更多注意材干

— 完 —

量子位 QbitAI · 头条号签约

温煦咱们,第一时辰获知前沿科技动态