豆包大模子团队开源RLHF框架,查验隐约量最高请示20倍

发布日期:2024-11-29 06:18 点击次数:127

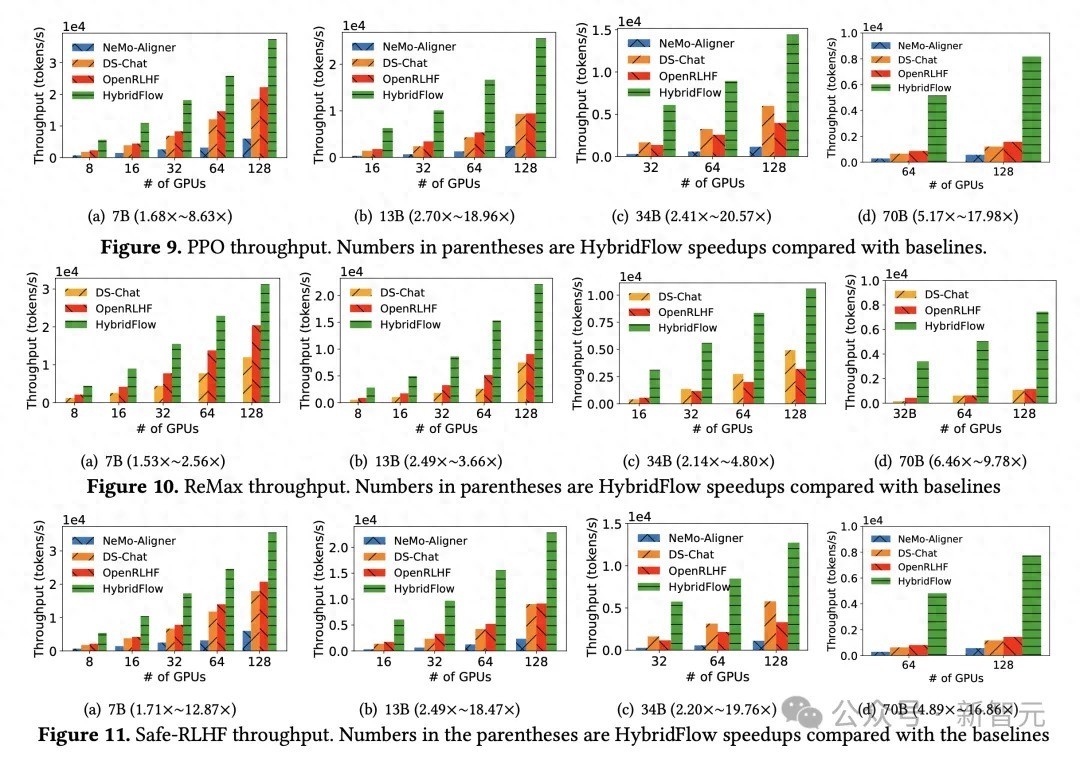

强化学习(RL)对大模子复杂推理才气请示相要害作用,但其复杂的狡计历程对查验和部署也带来了遍及挑战。近日,字节逾越豆包大模子团队与香港大学皆集淡漠 HybridFlow。这是一个天真高效的 RL/RLHF 框架,可权贵请示查验隐约量,缩小开拓和叹息复杂度。实验斥逐标明,HybridFlow 在各式模子范围和 RL 算法下,查验隐约量比拟其他框架请示了 1.5 倍至 20 倍。

在大模子后查验(Post-Training)阶段引入 RL 武艺,已成为请示模子质料和对皆东谈主类偏好的弥留时间。然则,跟着模子范围的禁止扩大,RL 算法在大模子查验中濒临着天真性和性能的双重挑战。传统的 RL/RLHF 系统在天真性和斥逐方面存在不及,难以适宜禁止泄露的新算法需求,无法充分发扬大模子后劲。

据豆包大模子团队先容,HybridFlow 接收混杂编程模子,将单适度器的天真性与多适度器的高效性相并吞,解耦了适度流和狡计流。基于 Ray 的漫衍式编程、动态狡计图、异构挪动才气,通过封装单模子的漫衍式狡计、合伙模子间的数据切分,以及复旧异步 RL 适度流,HybridFlow 约略高效地收场和试验各式 RL 算法,复用狡计模块和复旧不同的模子部署花样,大大请示了系统的天真性和开拓斥逐。

实验斥逐炫耀,不论 PPO 、ReMax 已经 Safe-RLHF 算法,HybridFlow 在扫数模子范围下平均查验隐约量均大幅最初于其他框架,请示幅度在 1.5 倍至 20 倍之间。跟着 GPU 集群范围扩大,HybridFlow 隐约量也得到追究膨胀。这成绩于其天确切模子部署,充分期骗硬件资源,收场高效并行狡计。同期,HybridFlow 约略复旧多种漫衍式并行框架(Megatron-LM 、FSDP 、vLLM ),振作不同模子范围的狡计需求。

跟着 o1 模子降生,大模子 Reasoning 才气和 RL 愈发受到业界情绪。豆包大模子团队暗意,将赓续围绕关联场景进行探索和实验。现在,HybridFlow 有计划论文已入选学术顶会 EuroSys 2025,代码也已对外开源。

HybridFlow开源贯穿:https://github.com/volcengine/veRL